Cuando yo era un chaval, un amigo nos mostró una foto en blanco y negro en la que su padre aparecía junto a Christopher Lee, uno de los actores que interpretó al conde Drácula. La había «tomado» durante un viaje a los Estados Unidos, algo que para mí, al menos en esos momentos, era todavía más exótico y más cool que posar junto al vampiro más famoso de todos los tiempos. Indudablemente, ninguno de nosotros creyó que la foto fuera auténtica. Pero allí estaba el padre de mi amigo, justo al lado del chupasangres.

Entenderás muy pronto que una cosa es una foto falsa en la que sales al lado de Christopher Lee o de la reina de Inglaterra y otra lo que estoy a punto de plantearte.

En 2019 se popularizó —al menos durante unas horas, que es lo que dura la novedad en nuestro mundo acelerado— un vídeo que combinaba la cara del actor Steve Buscemi con el cuerpo de la actriz Jennifer Lawrence. Y en 2020 un vídeo sustituía a Michael J. Fox y Christopher Lloyd por Tom Holland y Robert Downey Jr. en una escena de Regreso al futuro.

A principios de 2021, una conocida marca de cerveza «resucitaba» a través de la informática a la popular cantante y bailaora de flamenco Lola Flores, para aparecer en un spot publicitario.

Con independencia del resultado técnico —bastante logrado en los citados ejemplos, un poco más tosco en algunas tentativas orientadas al cine para adultos—, lo que debe ponernos sobre aviso es el uso futuro que de estas tecnologías puede hacerse. Por el momento nos resultan simpáticas e incluso nos hacen gracia. Pero, ¿y si llega un día en que sus usos e implicaciones resulten más problemáticos?

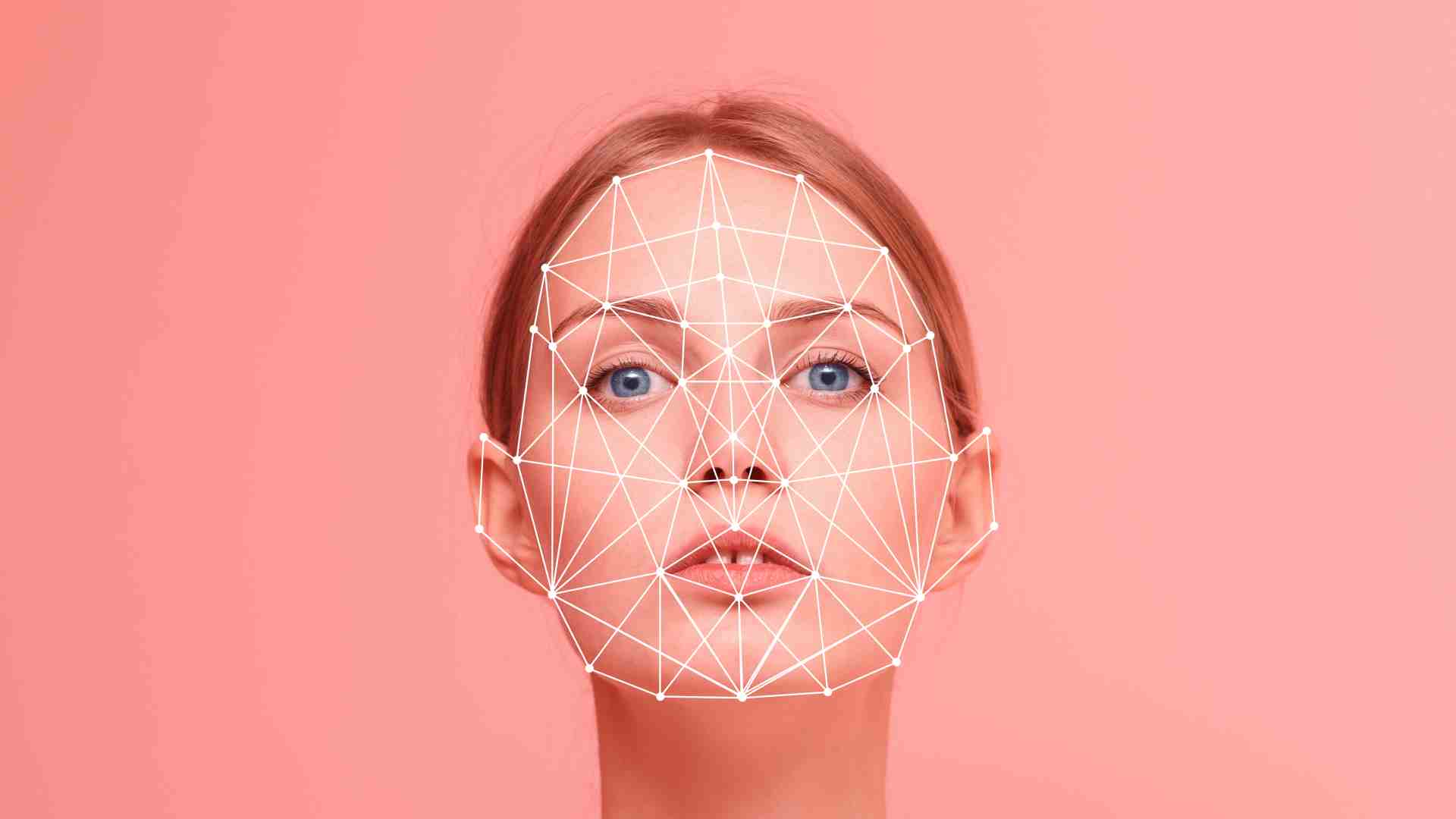

Las técnicas de deepfake, que es como se denomina a estos vídeos que acabo de mencionar, se apoyan en algoritmos y en llamada Inteligencia Artificial (o AI, el acrónimo de Artificial Intelligence). Mediante complejos cálculos, esta Inteligencia Artificial puede recopilar y adaptar rasgos faciales, corporales y un largo etcétera para construir imágenes casi indiscernibles de las originales, de las reales.

Al igual que en otras entradas arrojaba la pregunta acerca de quién diseña los algoritmos, según qué parámetros y con qué fines, podemos plantearnos qué intereses —más allá del uso lúdico o publicitario— puede haber detrás de estas creaciones o quién planta las semillas de la Inteligencia Artificial. Sólo así podremos comprender los riesgos que entrañan.

Antes de ello, quisiera hacer otra advertencia: del mismo modo que los algoritmos en sí mismos no son ni buenos ni malos —y, para según qué cosas, son incluso excelentes—, la Inteligencia Artificial tampoco tiene por qué suponer de manera necesaria una nueva manifestación de las fuerzas del mal. En realidad, la AI puede constituir un excelente mecanismo de seguridad, a través de procedimientos, como el reconocimiento facial, que impidan la suplantación de identidad o la comisión de delitos, o ser de gran utilidad en áreas como la medicina, la simulación de situaciones diversas o los videojuegos, y esto por mencionar tan sólo algunos campos. De nuevo, los problemas radican en su uso (o abuso).

Nada mejor que recurrir al ejemplo para ilustrarlo, y no es por contradecir a mi profesora de filosofía en el instituto.

Imagina que en un futuro indeterminado una persona recibe en uno de los grupos de Whatsapp de los que forma parte, en el muro de Facebook de uno de sus amigos o en cualquier otro portal de Internet, un vídeo en que puede verse al líder del partido político que tanto detesta en una situación comprometida (no me malinterpretes, recurro a los políticos porque suponen un ejemplo bastante gráfico, ya que moviliza razón y, sobre todo, emoción). El vídeo es completamente falso, pero es indistinguible de uno real (se trata de un deepfake muy logrado). El espectador tiene dos opciones básicas: cuestionarse la veracidad del mismo y comprobarla—tú podrías hacerlo en estos momentos, ya que hay disponibles a nuestro alcance algunas herramientas, como la web deepware.ai— o confiar sin más en su autenticidad. ¿Cuál crees que será la opción más probable?

Como has llegado hasta aquí, supongo que te inclinarás a pensar —y con razón— que la mayor parte de las personas tenderán a creer que es verdadero e incluso puede que lo difundan. Quiero señalar que esto no tiene por qué deberse a la mala fe o a que se trate de una persona necesariamente estúpida.

Como vimos en el capítulo «Un mundo hecho a medida», pocas personas se tomarán la molestia de verificarlo porque, aparte de que el proceso de verificación se ha convertido en algo tedioso y aburrido, dicho vídeo se ajusta a sus puntos de vista o a sus intereses, y además los refuerza.

Poco importa si con posterioridad se demuestra su falsedad. Baste como muestra el escaso impacto de los mecanismos de fact checking (o comprobación de hechos) ya existentes, dado que esa persona podría insistir en que dichas herramientas están manipuladas o al servicio del «enemigo» (¿recuerdas a Donald Trump acusando a los medios y a la prensa de ser propagadores de fake news y meros contenedores de basura informativa?). Poco importa porque, en cualquier caso, el daño ya estaría hecho y la semilla de la duda ya se habría sembrado.

Las malas hierbas son muy difíciles de erradicar.

Esto nos conduce a la cuestión de la crisis epistemológica de la que te hablé en la introducción y que prometí explicarte más tarde (gracias por esperar). La epistemología es la parte de la filosofía dedicada al estudio del conocimiento humano. Traducido a un lenguaje más coloquial, «crisis epistemológica» apunta a la imposibilidad de determinar qué es real y qué no.

Ahora bien, ¿qué sucede cuando ya no podemos confiar en lo que ven nuestros ojos? ¿Qué pasa cuando dudamos de los medios, repletos de noticias falsas y bulos? ¿Cómo ir más allá de la visión que nos ofrecen los algoritmos y los filtros burbuja que limitan nuestra visión del mundo y nos ofrecen una realidad que se adapta a nuestros gustos y a nuestra sensibilidad? ¿Cómo verificarlo todo cuando todo es susceptible de ser falso?

Y lo más importante: ¿a dónde nos conduce esta situación?

En la siguiente entrega hablaremos del totalitarismo: la amenaza fantasma… o no.

Me encanto el articulo!!.. Vivimos en un holograma?