Existen diferentes opiniones en la comunidad científica cuando se debate sobre las perspectivas de la Inteligencia Artificial (IA) a corto y medio plazo. Tampoco existe en absoluto consenso acerca del impacto que estas tecnologías tendrán en la sociedad ni de sus implicaciones en terrenos como la economía, las leyes o la carrera armamentística. Pero, sobre todo, cuando mayor es el desencuentro es al especular sobre la singularidad. Ese es el nombre que se ha otorgado al hipotético momento en que la máquina supere el nivel de la inteligencia humana, haciéndose con ello autosuficiente para rehacerse y mejorarse a sí misma. No existe consenso ni en el qué ni en el cuándo, ni mucho menos en el impacto que ello podría tener para la humanidad.

Con máquinas capaces de pensar al nivel humano o por encima de él, casi todos los escenarios que nos han presentado el cine y la televisión entrarían a priori dentro del campo de lo posible: la sociedad humana se convierte en una sociedad del bienestar, donde nadie tiene que trabajar y las enfermedades se curan mediante avanzadas técnicas de diagnóstico y tratamientos biotécnicos; la inteligencia humana se expande por el universo sobre máquinas inteligentes; los hombres conviven con robots; los robots esclavizan al hombre; bombas inteligentes de destrucción masiva acaban con la humanidad…

Algunos, los más optimistas, opinan que la singularidad se hará realidad a lo largo del presente siglo y que con ella nacerán sobre todo oportunidades beneficiosas para el ser humano. En el último extremo, esta nueva forma de vida emergente, la digital, podría ser el siguiente paso natural de la evolución de la vida en el universo. La vida basada en carbono daría paso a la basada en silicio y sería esta nueva forma de vida la llamada a expandirse por el cosmos.

Algunos otros, aun compartiendo la opinión de que la singularidad es inminente, no se muestran tan entusiasmados por las oportunidades como preocupados por los riesgos. Abogan por un planteamiento meditado del problema y por tratar de definir de antemano unas reglas que dibujen la línea de investigación a seguir en este campo, intentando garantizar siempre los máximos beneficios que esa tecnología pueda aportar al ser humano, evitando a la vez los peligros que potencialmente pudiera conllevar.

Existen otras opiniones más escépticas que piensan que la singularidad no será todavía alcanzable en centenares de años y que por ello resulta absurdo ponerse a pensar ahora en riesgos u oportunidades.

Tampoco faltan quienes opinan que la singularidad no se hará realidad nunca.

Para ver hasta qué punto la singularidad está al alcance de nuestras manos, vamos a construir una máquina réplica exacta de la mente humana. Y lo haremos aquí, en el laboratorio de Zenda y en el otoño de 2017. Nuestra máquina deberá sobrepasar todas las habilidades mentales de un ser humano, así como su capacidad de aprender, de pensar y de tomar decisiones. Vamos a ver con qué dificultades nos encontramos y hasta dónde somos capaces de llegar.

Buscaremos en primer lugar una tecnología capaz de emular los dos atributos básicos del cerebro humano: la memoria y la capacidad de procesamiento de la información, lo que habitualmente cuantificamos mediante el coeficiente intelectual.

La memoria

La información se almacena en la memoria de los ordenadores en forma de códigos binarios (bytes), como explicábamos en uno de los primeros artículos de esta sección (De lo analógico a lo digital). Para hacernos una idea de magnitudes, echemos un vistazo a nuestro alrededor y detengámonos en la siguiente tabla:

Un archivo de texto plano = 150.000 bytes

Un mp3 de música = 3.000.000 bytes

Una película DVD = 1.000.000.000 bytes

Toda la información de Google = 2. 000.000.000.000.000 bytes

Toda la información de Internet = 200. 000.000.000.000.000.000 bytes

En el Centro de supercomputación nacional de la provincia de Wuxi, en China, reside el que es considerado hoy en día como ordenador más potente del mundo, el Sunway TaihuLight. Parte de los 300 M $ que costó se invirtieron en dotarle de una memoria que tiene una capacidad, en cifra de bytes, algo por encima de un uno seguido de quince ceros (1,3 x1015 bytes).

Sunway TaihuLight

El cerebro humano no funciona con bytes, pero, no sin dejar de asumir cierto riesgo, vamos a utilizar esta unidad para establecer una similitud con la máquina.

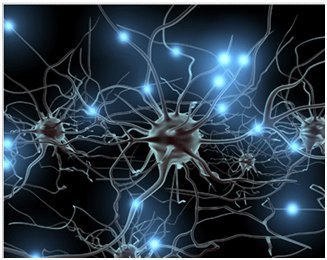

El cerebro alberga cerca de cien mil millones de neuronas, tantas como estrellas hay en nuestra galaxia y como galaxias conocemos en el universo, cada una conectada en promedio con otras 7.000 a través de las denominadas conexiones sinápticas. Aunque todavía se trata de una materia bajo investigación, existe un consenso en afirmar que la memoria humana se aloja en estas redes sinápticas. Al recibir estímulos o información del exterior se crean nuevas conexiones neuronales y se eliminan otras. Cada segundo se crea alrededor de un millón de nuevas sinapsis en nuestro cerebro.

La primera información que almacena el cerebro del ser humano es la recibida en forma de herencia genética a través del ADN. Esta información está condensada en el equivalente a 2.000.000.000 bytes de memoria en una máquina, menos de la mitad de lo que puede almacenar este pen drive que tengo a mi lado.

Sin embargo, a medida que se desarrollan las redes neuronales, el almacenamiento del cerebro crece de forma asombrosa. Se especula con que la capacidad de memoria (en bytes) de un adulto es del orden de un dos seguido de quince ceros (2x 1015 bytes), es decir, casi el doble de la capacidad de almacenamiento del Sunway TaihuLight y más o menos lo que se necesitaría para guardar toda la información que tiene actualmente Google.

En términos de memoria, la máquina y el cerebro no solo se diferencian en su capacidad de almacenamiento. También difieren en la forma en que gestionan la información almacenada.

El ser humano busca esta información conociendo a priori qué se busca. La memoria del cerebro es auto asociativa y trabaja por asociación más que por ubicación. Es algo parecido a cómo funcionan los buscadores de Internet: la búsqueda se basa en la especificación de algo asociado o relacionado con lo que se desea encontrar. Si no se cultivan permanentemente estas relaciones asociativas, el cerebro humano tiende a vaciar su memoria prescindiendo de algunos recuerdos. Esta es la causa que nos impide aprovechar al máximo nuestra capacidad de memoria.

Por el contrario, los ordenadores buscan la información conociendo de antemano dónde está, como cuando antiguamente consultábamos la ficha de un libro en la biblioteca para localizarle en la estantería. Es decir, la memoria del ordenador, por así decirlo, es direccionable. Esto hace que la información que memorizan no desaparezca nunca.

El procesamiento de la información

La memoria humana es pieza clave de nuestro cerebro. Además de guardar allí los recuerdos de toda la vida, la utilizamos en los procesos cognitivos y en la interpretación o el procesamiento de la información que recibimos de nuestro entorno.

El procesamiento es una manifestación de la inteligencia en virtud de la cual la mente accede a un estímulo o a una información, la interpreta y desencadena una acción. Esta acción puede derivar simplemente en la toma de una decisión o en la generación de otra información distinta. Por ejemplo, un traductor parte de un texto en un idioma y lo transforma en el mismo texto, pero expresado en otra lengua.

La manera en que se realiza la transformación y las decisiones intermedias forman parte del aprendizaje. El ser humano sabe cómo hacer las cosas porque previamente ha aprendido a hacerlas. La máquina actúa exactamente igual.

Aunque la forma en que el cerebro humano procesa la información sigue siendo un misterio, se ha avanzado mucho en replicar sus resultados sobre un ordenador. Es lo que algunos investigadores han denominado “problema fácil”. Todas esas aplicaciones que hemos venido mencionando en esta serie de entregas (AlphaGo, Watson, Siri…) lo han conseguido ya.

El problema se ha reducido casi a una cuestión de dimensiones, a dotar al ordenador de la capacidad de proceso que necesitan esas aplicaciones para ejecutarse.

La capacidad de proceso de un ordenador se cuantifica normalmente en términos de velocidad, de lo rápido que es ejecutando instrucciones. Estamos acostumbrados a utilizar como unidad representativa de la velocidad el Hertz (Hz), que indica los ciclos de procesamiento por segundo que puede realizar la máquina. Así, cuando hablamos de un PC de 2 GHz (2.000.000.000 Hz), nos estamos refiriéndonos a la velocidad de su procesador.

Las arquitecturas de procesamiento en paralelo, que reparten la computación entre varios ordenadores trabajando simultáneamente, están permitiendo desplegar unidades de proceso de forma modular y alcanzar rendimientos espectaculares.

Los próximos avances en el procesamiento en paralelo se registrarán en el terreno de los ordenadores cuánticos que, como recordará el lector de artículos anteriores en esta sección, se basan en el principio de superposición cuántica que manifiestan las partículas subatómicas en determinadas condiciones.

Las neuronas del cerebro humano actúan exactamente así, como decenas de miles de millones de ordenadores trabajando en paralelo, multiplicando de esta forma y en la misma medida su velocidad. Los expertos especulan con que la velocidad de proceso de cada neurona puede estar en el rango entre 0,000001 y 0,000002 GHz, lo que, de ser cierta esta aproximación, deberíamos aceptar que el cerebro procesa a velocidades de decenas de miles de GHz. En otras palabras, algo equivalente a la capacidad de proceso del ordenador más potente del mundo, el Sunway TaihuLight.

Me imagino que esta conclusión no dejará de sorprender a nadie. Resulta bastante evidente que si yo quisiera competir con un ordenador haciendo multiplicaciones de varias cifras, tendría todas las de perder, a pesar de esa poderosa máquina que tengo por cerebro.

Los ordenadores ya han demostrado que son capaces de derrotar a un campeón del mundo de ajedrez (Deep Blue IBM, 1996, con una capacidad de proceso no muy superior a nuestros actuales teléfonos móviles), de vencer a los mejores jugadores de Jeopardy (Watson IBM, 2011), o al campeón europeo de Go (Google DeepMind Alpha Go, 2015). Esta aparente ventaja de la máquina sobre el hombre es debido a que el cerebro humano no utiliza realmente toda su capacidad. Y no es porque, como se ha venido repitiendo con frecuencia, solo usemos una mínima parte del mismo.

Nuestro cerebro es capaz de hacer prácticamente de todo, pero está específicamente entrenado para hacer bien solo determinadas cosas. Es evidente que un corredor de maratón puede disputar una carrera de 100 metros lisos, pero su rendimiento estaría muy lejos del de cualquier especialista en esa distancia.

El ordenador nos supera en tareas específicas para las que ha sido diseñado, pero nosotros somos mucho más eficientes que él en otras muchas, como interpretar la realidad que nos rodea, orientarnos o reconocer los sabores. Y sobre todo en integrar todos esos estímulos externos y reaccionar ante la sensación final que nos causan.

Si en lugar de emular en un ordenador el cerebro humano tratáramos solo de reproducir su rendimiento jugando al ajedrez, nos bastaría con cualquier PC. Pero no olvidemos que nuestro propósito es alcanzar la singularidad, crear un atleta que sea campeón de 100 metros y a la vez de maratón.

Conclusión

Queriendo convertir una máquina en un cerebro humano, nos hemos encontrado con que nuestro cerebro es tanto o más potente que el más potente de los ordenadores existentes en el planeta. Hemos visto también que, desde un punto de vista tecnológico, esto no sería un condicionante drástico y que la tecnología actual es capaz de darnos ya los recursos que necesitamos para insistir en nuestro empeño. Probablemente, nuestras mayores dificultades serían solo de tipo funcional (tamaño, consumo energético…) y financiero.

Para crear este cerebro sintético necesitaríamos un ordenador tan potente como el Sunway TaihuLight, es decir, 2x 1015 bytes de memoria, 100.000 GHz de velocidad de proceso, una sala de al menos cien metros cuadrados, una acometida eléctrica por encima de los 15 megavatios (que es el equivalente al consumo de un millón de PCs) y un presupuesto de más de 300 millones de dólares. Pero esto tampoco debe ser algo que nos preocupe, al menos a corto plazo.

Existen dos leyes que inexorablemente se vienen cumpliendo desde hace decenas de años. La conocida Ley de Moore y la Ley de rendimientos acelerados de Kuzweil. La primera establece que cada dos años se duplica el número de transistores que caben en un circuito integrado. En otras palabras, la tecnología tiende aceleradamente a multiplicar su rendimiento y en paralelo a dividir su coste.

La ley de Kurzweil, por otro lado, dice que el avance de la tecnología hace que las cosas pasen más deprisa. En los próximos diez años experimentaremos un cambio similar al experimentado en el último siglo y en las dos próximas décadas otro equivalente a un milenio.

Desde la primera memoria (tubo Williams) que se desarrolló en 1947 con capacidad de poco más de 60 bytes hasta nuestros días, la evolución de la tecnología en este terreno ha sido exponencial. Se están desplegando ya centros de proceso de datos dotados con memorias de capacidades (en bytes) del orden de un uno seguido de 21 ceros (10 21 bytes). Y lo que es más importante, desde que se lanzó al mercado en 1980 el primer disco de “alta capacidad” (tan solo 1.000.000.000 bytes) hasta nuestros días, el coste de la memoria se ha devaluado medio millón de veces.

Cumpliendo estrictamente la ley de Moore, el hardware de las unidades de procesamiento ha experimentado un camino muy similar al recorrido por los dispositivos de almacenamiento. El coste de la computación ha descendido un trillón de veces desde que aparecieron los primeros ordenadores y la tendencia al día de hoy no ha cambiado. Una evolución paralela se aprecia al observar el tamaño de los dispositivos, lo que podríamos llamar capacidad de procesamiento por centímetro cuadrado. En los años ochenta yo trabajaba en un centro de proceso de datos con un ordenador que ocupaba una sala de casi doscientos metros cuadrados. La potencia de ese ordenador era inferior a la del PC en el que ahora estoy escribiendo.

Consecuentemente, no parece ilusorio esperar que en el plazo de quince o veinte años tengamos a nuestro alcance máquinas de tan solo unos centímetros cuadrados, capaces de emular al cerebro humano y con precios de no más allá del equivalente a unos miles de euros.

Ya tenemos el hardware de nuestro cerebro. Necesitamos ahora desarrollar el software.

En la próxima entrega daremos ese paso, abordando el verdadero gran reto de la singularidad. Trataremos de “educar” a nuestra máquina, de instruirla para que adquiera conocimientos por sí misma, de enseñarla a “pensar” y a tomar decisiones y, finalmente, intentaremos también dotarla de consciencia.

Zenda es un territorio de libros y amigos, al que te puedes sumar transitando por la web y con tus comentarios aquí o en el foro. Para participar en esta sección de comentarios es preciso estar registrado. Normas: