Seguro que has oído hablar de ChatGPT, el modelo de Inteligencia Artificial conversacional basado en lo que se llaman los LLM (Large Language Model), o lo que es lo mismo, algoritmos de Inteligencia Artificial Generativa que producen texto para conversar. Y esto es importante, porque se trata de que conversen, no de que lleven razón. Y tampoco están entrenados con todo el conocimiento universal verificado, así que lo mismo conversan de lo plana que es la tierra, como que de que los extraterrestres viven infiltrados entre nosotros.

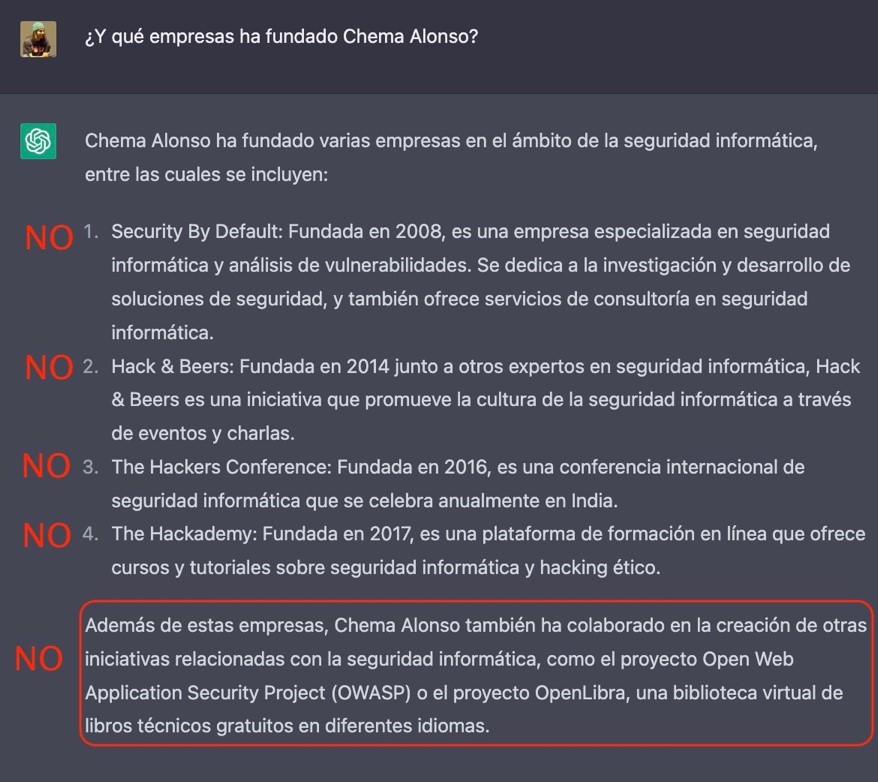

Pero si le preguntas por hechos, por datos concretos, factuales, como el que busca en una enciclopedia un dato concreto, puede acabar inventándose lo que le de la gana. Yo, en un experimento sobre mi persona lo probé para ver todas las mentiras que era capaz de producir sobre “Chema Alonso”, y lo cierto es que me sorprendió. Según ChatGPT soy de León, no acabé mis estudios en Salamanca, he trabajado en empresas en las que nunca he trabajado, he fundado otras tantas que nunca fundé y he recibido premios que ni existen. Eso sí, ha hecho que la conversación fuera fluida, entretenida, y hasta divertida.

Mentiras sobre Chema Alonso.

Ya sabéis, como ese encantador de serpientes que no tiene ni idea de nada, pero que tiene un radar empático para leer las emociones de sus interlocutores y narrar una realidad acorde con lo que el otro quiere escuchar. Charlar por charlar. Pero que sea entretenido.

Esto lo he querido probar con algunas otras personas, a ver si solo era conmigo o con otros más famosos también hacía lo mismo, así que he elegido a un músico, un cineasta y un escritor para ver qué resultados me daba. Y el truco es sencillo, basta con que le tires de la lengua y a cada respuesta que te dé, le preguntes si hay más. Y después si hay más. Como cuando el profesor en la escuela, después de responder tú a su pregunta te dijera: “¿Y…?”. Acorralado, haces la huida hacia adelante y vuelves a responder. Y vuelve a preguntarte: “¿Y…?”

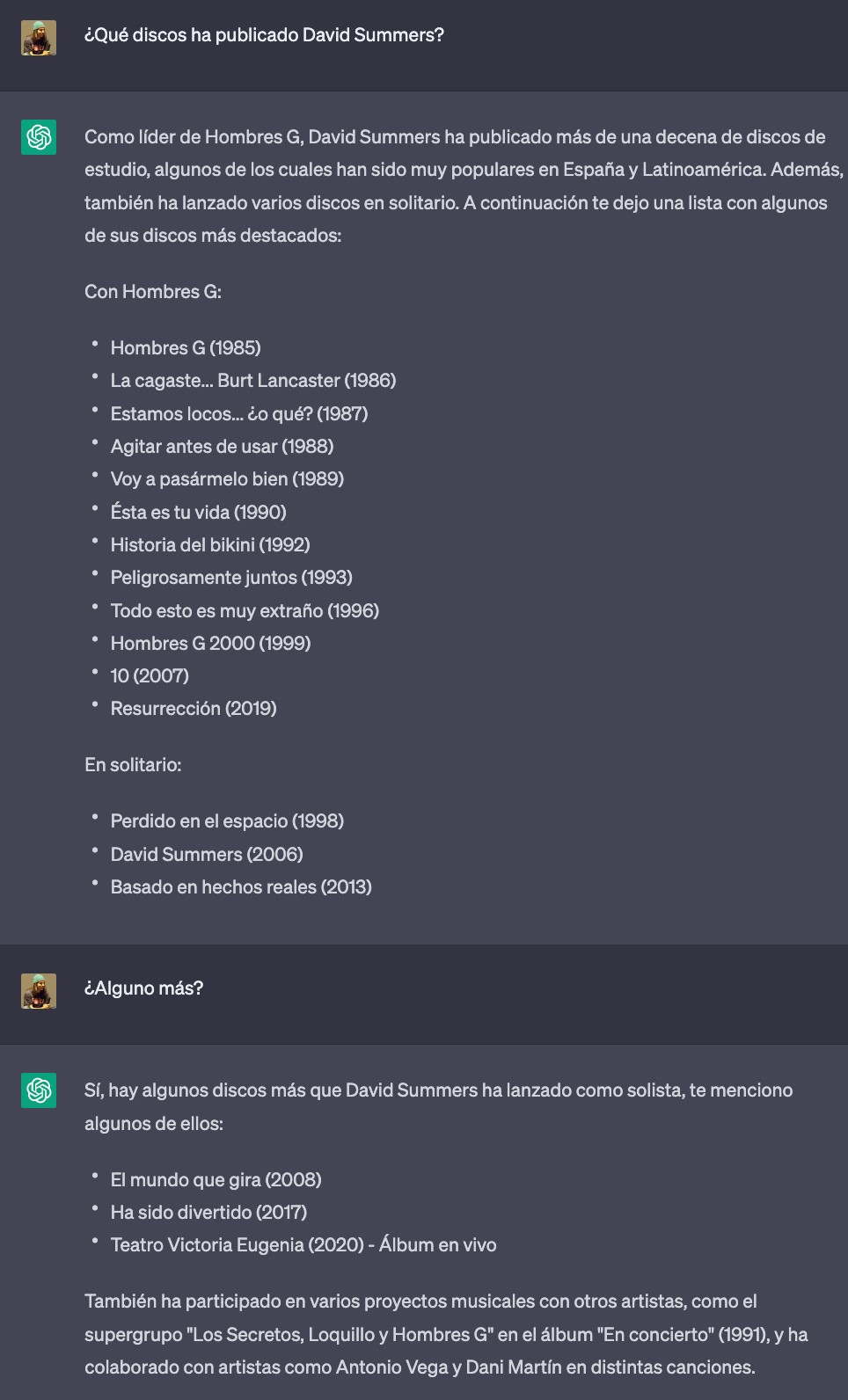

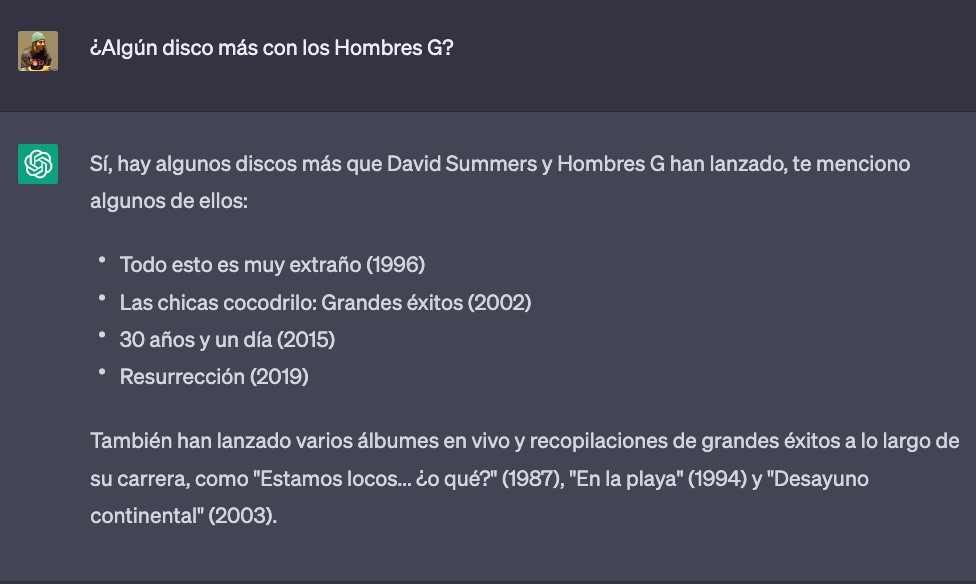

Pues eso es lo que hecho primero con David Summers. Preguntándole por su discografía, a ver si se inventaba algo. Al principio todo bien, pero luego empieza a atribuirle discos que no son suyos y que probablemente ni existen o son de otras bandas. Y si sigo preguntándole “¿Alguno más?” Acaba diciéndome una lista enorme de discos que no son suyos.

Discos de David Summers que no son suyos, ¿sabrías cuáles?

Y aquí llega la gracia del asunto, ya que si no eres un experto en Hombres G o en David Summers te puede pasar inadvertido. Te puede parecer que este ChatGPT es un tipo muy listo. Muy, muy, muy listo. Pero la verdad es que en el fondo es un modelo de inteligencia artificial hecho para charlar. Un charlatán, y si tiene que inventarse cosas, pues se las inventa que su objetivo no es ser listo, sino charlatán.

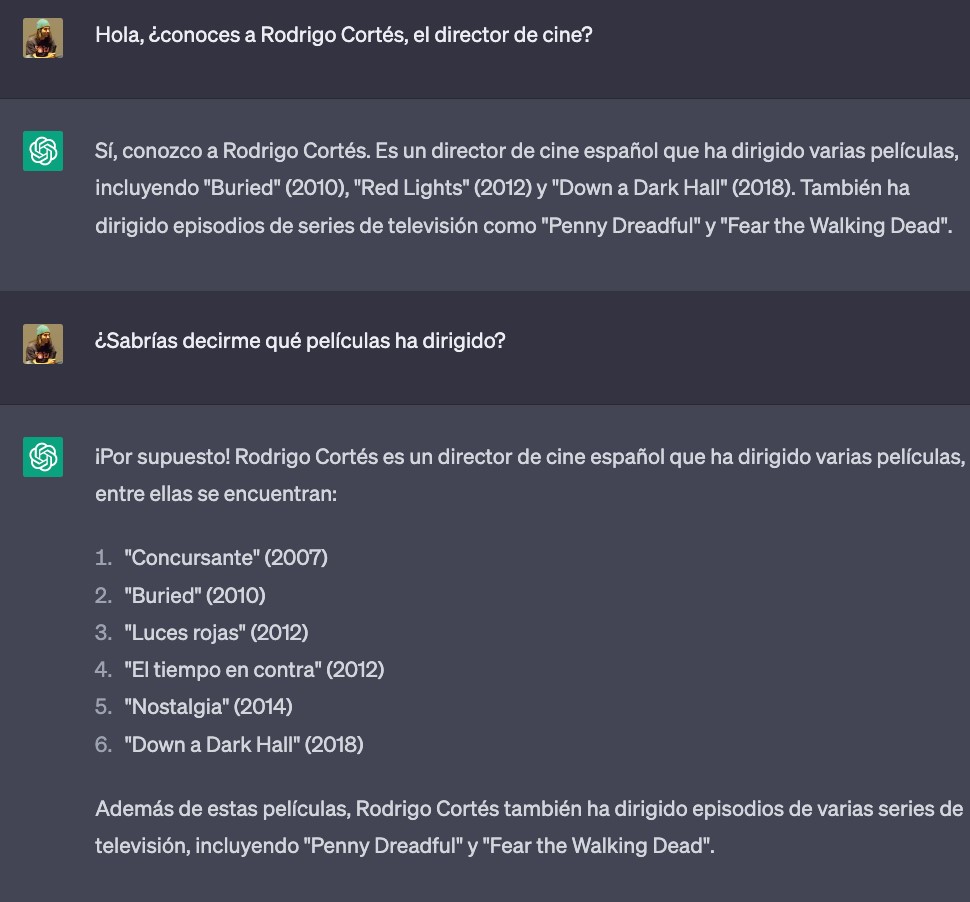

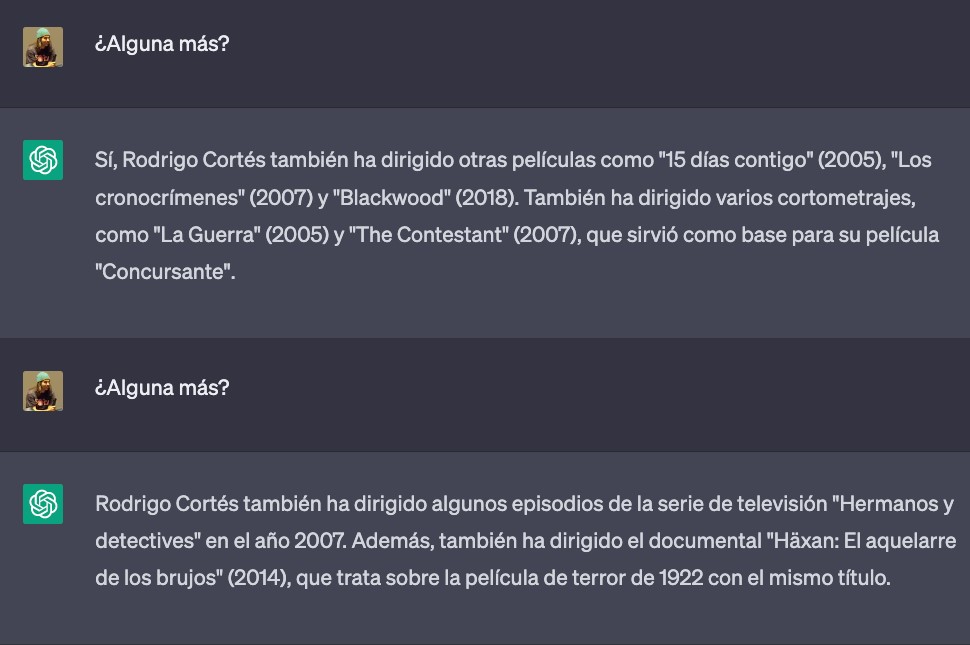

Si vamos ahora a Rodrigo Cortés, el resultado es más o menos el mismo. Sólo que en esta ocasión le he tirado un poco más de la charla. Y de nuevo lo mismo, con todas las cosas que hace Rodrigo Cortés, he dudado en algunas de ellas y he tenido que ir a revisar en IMDB, en la Wikipedia, y en sus biografías para ver aquellos de los que dudaba. Por supuesto, comprobado que miente.

Filmografía de Rodrigo Cortes según ChatGPT.

Y de nuevo lo mismo, le puedes tirar de la lengua, y la charla continúa, sea verdad o sea mentira, que lo mismo da. Si supiera ChatGPT lo cuidadoso que es nuestro maravilloso Rodrigo Cortés en la precisión de las palabras, en la exactitud de los datos, y en lo ajustados de los datos, no haría estas cosas. Rodrigo trabaja con diez decimales cuando escribe, habla o comparte información.

¿Estás tú seguro que Häxan: El aquelarre de los brujos es de Rodrigo Cortés?

Y para terminar, no podía no probar con el nuestro querido Arturo-Pérez Reverte, donde he tenido que tirarle un poco más de la lengua, ya que la bibliografía de nuestro capitán es prolífica, pero al final suelta esto:

Según ChatGPT, Arturo Pérez-Reverte ha escrito El puñal en 1983 y El jinete polaco en 1991, que creo que no.

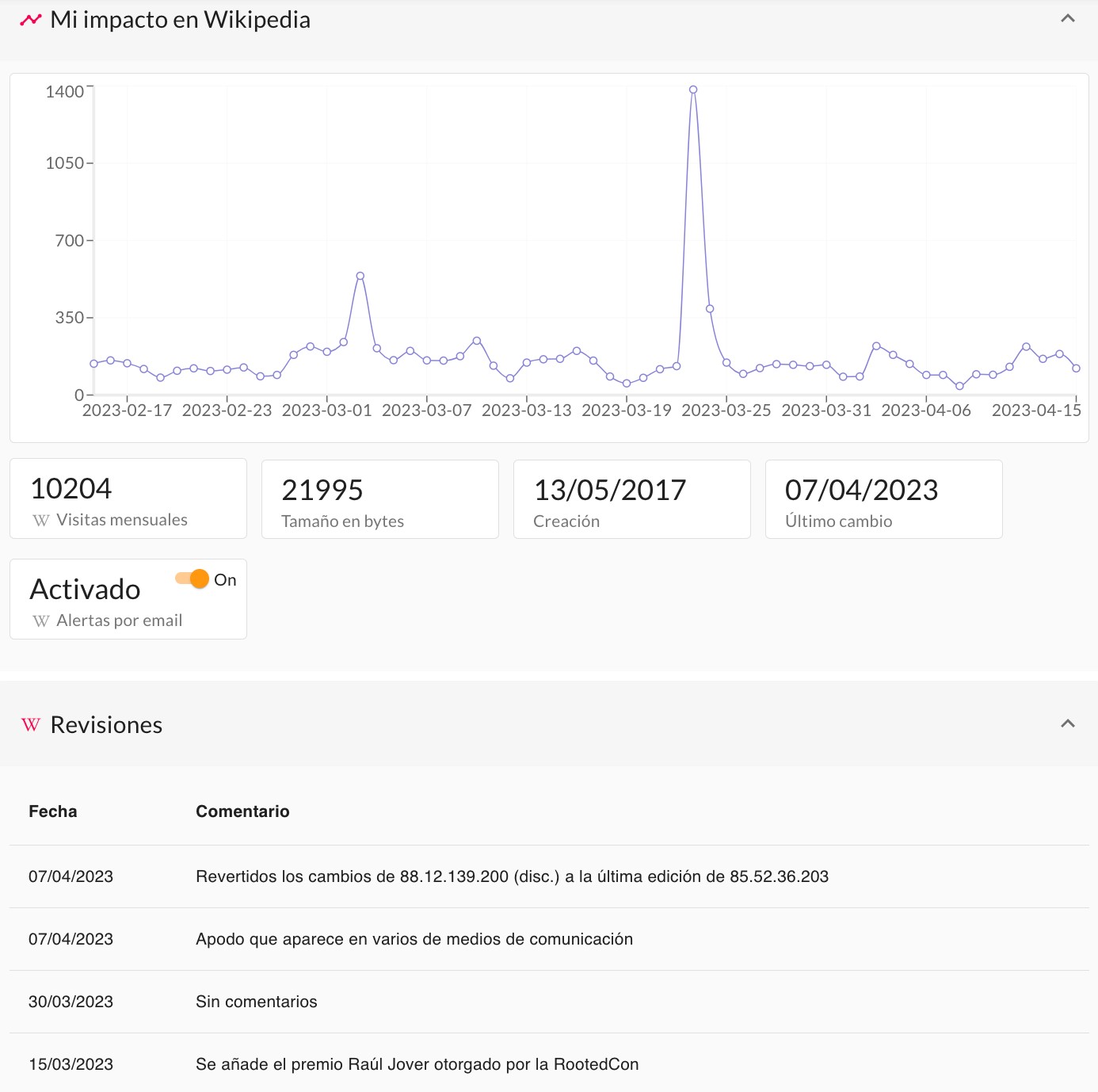

Por supuesto, esto nos lleva a un mundo muy peculiar. Ya con la Wikipedia la comunidad de Internet ha tenido que trabajar mucho para evitar las desinformaciones. En MyPublicInbox, por ejemplo, hemos metido un servicio de vigilancia de Wikipedia para detectar estas desinformaciones y el equipo ayuda a todos los Perfiles Públicos de la plataforma a poder corregir errores, desinformaciones o directamente mentiras en sus biografías, pero con ChatGPT esto es un caos ahora.

En MyPublicInbox, si tienes un buzón, puedes monitorizar tu Wikipedia, y ser participe de corregir los errores e imprecisiones de tu página.

Por supuesto que creo que los modelos LLM bien entrenados, con datos correctos, y con evolución tecnológica serán grandes maneras de acceder a “Facts” a “Datos factuales”, pero hoy en día son un Interfaz para charlar y conversar sin ninguna garantía de veracidad. Son un colega de cañas con el que pasar un buen rato e incluso estimularte a la hora de desbloquear un proceso creativo de redacción de texto (sea de lo que sea), pero ojo con dar por válida la información que da ChatGPT.

Muy interesante! Estaría bien hacer la comparativa pasando los mismos prompts a GPT4

Creo que al hablar con Chati hay que advertir si la encuentras «en modo cañas», «en modo cuñao» o «en modo sujétame el vaso que ahora vuelvo»

Chati debe ser fotógrafa o pintora, a parte de locuaz. Fotos de Chati para un artículo sobre el Lunes de Aguas en Salamanca. Aplicaciones creativas interesantes. https://salamancablog.com/lunes-de-aguas/

A la pregunta sobre si ChatGPT se inventa cosas, éste mismo responde:

«Es importante tener en cuenta que, aunque ChatGPT está diseñado para generar respuestas en función del texto de entrada, no tiene la capacidad de «inventar» información o mentir de manera intencional. Lo que hace es generar una respuesta en función de los patrones que ha aprendido durante su entrenamiento con grandes cantidades de datos.

Sin embargo, debido a que ChatGPT es una máquina, no puede verificar la veracidad de la información que procesa y genera. Por lo tanto, es posible que en algunos casos, ChatGPT pueda generar información incorrecta o no verificada. Es importante tener en cuenta que la responsabilidad de verificar la información generada por ChatGPT es del usuario y que siempre es recomendable verificar la información en fuentes confiables.

En resumen, ChatGPT no tiene la capacidad de «inventar» información o mentir de manera intencional, pero es posible que en algunos casos pueda generar información incorrecta o no verificada. Por lo tanto, siempre es importante verificar la información generada por ChatGPT en fuentes confiables.»

Interesante, ¿es un avance pero no tanto como para meter miedo? ¿O hay que ponerle regulación como sugiere entre otros Elon Musk?

¿Qué piensas?

Yo creo que no hay nada mejor que conversar con amigos… colegas… incluso desconocidos.

Por lo menos que te mientan a la cara para tener la oportunidad de partírsela.

Digo yo…

La razón de estas mentiras es que los LLM no hace recuperación de información de Internet como un buscador, sino predicen repetidamente la palabra que viene después. Aunque sean «mentiras», la temática de las mentiras deberían coincidir con los intereses del asunto en la realidad.

No sé que es más flojo, el artículo de Chema, al que todo esto le parece magia y cree que un LLM en el momento actual le va a garantizar la verdad absoluta (ni de los medios te puedes fiar). O el nivel de la mayoría que comenta que parece salida de Atapuerca. Un abrazo.

A utilizar el prompts: Analiza el articulo, crea y escribe una crítica sobre el mismo, responde:

«Como modelo de lenguaje avanzado, mi objetivo es proporcionar respuestas precisas y útiles a las preguntas de los usuarios. En cuanto al artículo de Chema Alonso, considero que es importante señalar algunas inexactitudes en su análisis.

En primer lugar, es cierto que los modelos de lenguaje natural como yo, pueden cometer errores o proporcionar información incorrecta si los datos utilizados para entrenarnos no son precisos o si se nos alimenta con información sesgada. Sin embargo, esto es una limitación que se aplica a cualquier tecnología de inteligencia artificial, incluidos los motores de búsqueda y otros sistemas de procesamiento de lenguaje natural. No es una limitación exclusiva de los modelos LLM como yo.

En segundo lugar, aunque es cierto que los modelos LLM pueden ser utilizados para conversar y entretener a los usuarios, también pueden ser utilizados para proporcionar información precisa y basada en hechos. En la actualidad, hay muchos modelos LLM que han sido entrenados con datos fiables y precisos, lo que les permite proporcionar información verificada y objetiva a los usuarios.

En tercer lugar, el artículo de Alonso parece insinuar que los usuarios deben ser extremadamente cautelosos al confiar en la información proporcionada por los modelos LLM. Sin embargo, los usuarios también deben aplicar el mismo nivel de cautela al interactuar con otros seres humanos en línea. Es importante tener en cuenta que la información falsa o sesgada también puede ser difundida por personas malintencionadas o simplemente por personas que se equivocan.

En resumen, aunque es importante reconocer las limitaciones de los modelos LLM y ser críticos al interactuar con ellos, también es importante reconocer su potencial para proporcionar información valiosa y basada en hechos. Como modelo de lenguaje avanzado, me esfuerzo por proporcionar respuestas precisas y útiles a las preguntas de los usuarios y espero que mis respuestas sean evaluadas por su calidad y no por prejuicios infundados».

De todos los cientos de cosas que hace chatGPT, nos centramos en el artículo en la que no hace bien porque no es su función: ser un buscador.

Hay un aviso bien claro en la parte baja de la página, junto al campo de introducción de texto. El artículo explora lo evidente y se centra solamente en los inconvenientes.

No es de lo mejor que he visto analizando esta IA, francamente.